ChatGPT ha demostrado su capacidad a la hora de escribir: su uso en el ámbito académico se está haciendo (¿peligrosamente?) popular, y su forma de redactar textos —con distintos estilos e imitando a ciertos autores— es convincente. Hay medios que ya están comenzando a usar estos motores para redactar contenidos, y la pregunta es si los escritores profesionales deben estar preocupados. La respuesta, al menos por ahora, parece ser un contundente no.

¿Se puede medir la creatividad? Un reciente estudio realizado por investigadores de Salesforce y la Universidad de Columbia ha querido averiguar cómo se aprecian actualmente los textos escritos por escritores profesionales, por escritores aficionaods y por un modelo de IA generativa. La idea era evaluar la "creatividad como producto" a través una variante del test de Torrance de Pensamiento Creativo (TTCT).

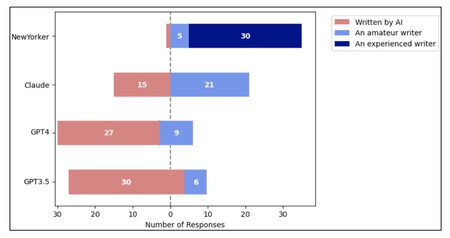

Aquí se muestra cómo calificaban los expertos cada relato: la mayoría de los de The NewYorker eran identificados como procedentes de autores profesionales, mientras que solo Claude obtenía bastantes relatos que eran identificados como de escritores aficionados. Los relatos de ChatGPT se identificaron con mucha frecuencia como escritos por una IA. Fuente: ArXiv.

Aquí se muestra cómo calificaban los expertos cada relato: la mayoría de los de The NewYorker eran identificados como procedentes de autores profesionales, mientras que solo Claude obtenía bastantes relatos que eran identificados como de escritores aficionados. Los relatos de ChatGPT se identificaron con mucha frecuencia como escritos por una IA. Fuente: ArXiv.

Las pruebas. En el estudio se creó un banco de pruebas con 48 relatos cortos de unas 1.400 palabras. 12 de ellos estaban creados por escritores profesionales, y 36 por tres grandes modelos de lenguaje (LLMs) aplicados a sus respectivos chatbots: ChatGPT (GPT-3.5), ChatGPT (GPT-4) y Claude 1.3. Reclutaron a un equipo de 10 expertos en escritura creativa, que gestionaron las pruebas del TTCT (en este caso, TTCW, por 'Writing' y no 'Thinking') realizando tres evaluaciones distintas por cada relato.

La IA, mediocre. En los resultados comprobaron cómo "los relatos generados por los LLM "tienen entre tres y diez veces menos probabilidades de superar las pruebas TTCW que los relatos escritos por expertos". La conclusión del estudio es obvia, y subraya "la competencia de escritores experimentados para evocar la creatividad, superando a los LLM por un margen considerable".

ChatGPT tiene mucho que aprender. De hecho, los investigadores también evaluaron cómo estos LLM podían mejorar en este ámbito y en estas pruebas para evaluar su creatividad. Según los expertos los LLM "no solo tienen un doble reto en la producción de contenidos intrínsecamente creativos, sino que además carecen de la delicadeza necesaria para evaluar la creatividad como lo hacen los expertos".

Sorpresa. Estos resultados son en cierto modo sorprendentes, sobre todo porque las herramientas que existen para detectar textos generados por una IA no acaban de ofrecer la confianza que se esperaba. OpenAI lanzó la suya propia y acabó retirándola tras admitir que no funcionaba con la precisión suficiente.

Seguimos teniendo un problema. Parece que los escritores profesionales pueden (podemos) estar tranquilos, pero eso no quita para que ya esté habiendo problemas con este tipo de motores de IA generativa. Lo vemos especialmente en Amazon, donde están apareciendo un gran número de títulos escritos por motores de IA que incluso le roban el nombre a autores humanos.

Imagen | Xataka con Bing Image Creator

Ver 5 comentarios